بودجه خزش (Crawl Budget) چیست؟ اهمیت و راهکارهای بهینهسازی آن برای سئو

در دنیای وسیع و پویای وب، جایی که میلیاردها صفحه برای جلب توجه موتورهای جستجو با یکدیگر رقابت میکنند، مفهومی کلیدی و اغلب نادیده گرفته شده به نام «بودجه خزش» یا «Crawl Budget» وجود دارد. تصور کنید گوگل یک کتابخانه عظیم و بیپایان است و رباتهای خزندهی آن (Googlebot) کتابدارانی هستند که وظیفه دارند هر روز میلیونها کتاب (صفحه وب) جدید را بررسی، فهرستنویسی و در قفسههای مناسب جای دهند. اما منابع این کتابداران، اعم از زمان و انرژی، نامحدود نیست. در نتیجه، آنها باید هوشمندانه تصمیم بگیرند که کدام کتابها را با چه اولویتی و با چه سرعتی بررسی کنند. این تخصیص منابع، در دنیای سئو، «بودجه خزش» نامیده میشود. درک عمیق این مفهوم و بهینهسازی آن، مرز میان یک وبسایت موفق با صفحاتی که به سرعت ایندکس شده و در نتایج جستجو میدرخشند و وبسایتی که صفحات ارزشمند آن در بایگانی دیجیتال گم میشوند را ترسیم میکند. این مقاله به صورت جامع و تخصصی به کالبدشکافی این مفهوم حیاتی پرداخته و راهکارهای عملی برای مدیریت و افزایش آن را پیش روی شما قرار میدهد.

بودجه خزش یا Crawl Budget چیست؟

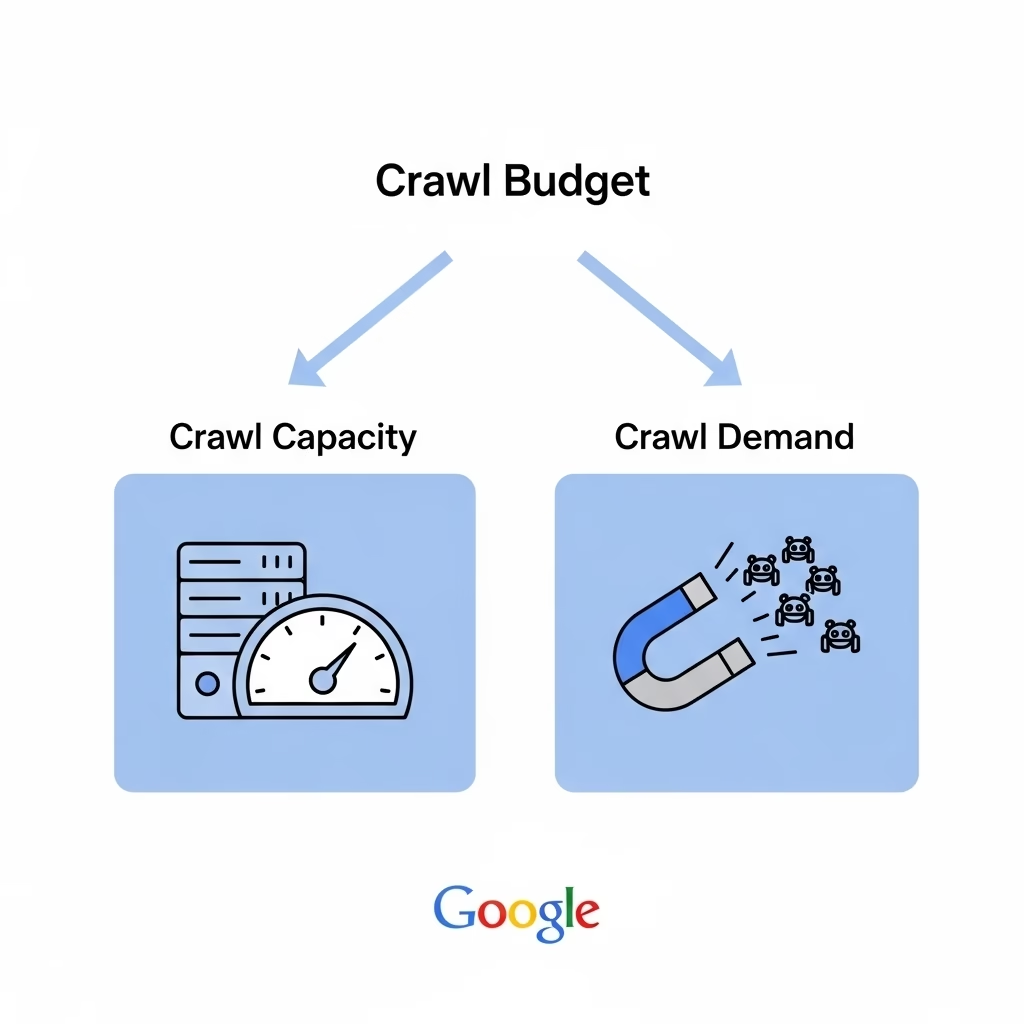

بودجه خزش (Crawl Budget) به تعداد صفحاتی اشاره دارد که رباتهای موتور جستجو، مانند گوگلبات، میتوانند و میخواهند در یک بازه زمانی مشخص از یک وبسایت بخزند (Crawl) و ایندکس کنند. این مفهوم، ترکیبی از دو عامل کلیدی است که توسط خود گوگل تعریف شده است: «ظرفیت خزش» (Crawl Rate Limit) و «تقاضای خزش» (Crawl Demand). درک این دو مؤلفه برای فهم کامل کرال باجت ضروری است. عدم توجه به این مسئله میتواند منجر به ایندکس نشدن صفحات مهم، تأخیر در مشاهده نتایج تلاشهای سئو و در نهایت، از دست دادن ترافیک ارگانیک شود. بهینهسازی صحیح بودجه خزش به معنای هدایت هوشمندانه رباتهای گوگل به سمت مهمترین و باارزشترین صفحات سایت است.

ظرفیت خزش (Crawl Rate Limit)

ظرفیت خزش یا محدودیت نرخ خزش، به حداکثر تعدادی از درخواستهای همزمان که گوگلبات میتواند به سرور شما ارسال کند بدون اینکه عملکرد آن را مختل کند، اشاره دارد. گوگل همواره تلاش میکند تا یک «مهمان خوب» برای وبسایت شما باشد و با ارسال درخواستهای بیش از حد، باعث کندی یا از دسترس خارج شدن سرور نشود. این ظرفیت بر اساس دو فاکتور اصلی تعیین میشود: سلامت سرور و پاسخگویی آن. اگر سرور شما سریع و بدون خطا به درخواستهای گوگل پاسخ دهد، گوگل به تدریج نرخ خزش را افزایش میدهد. اما اگر سرور با کندی پاسخ دهد یا خطاهایی مانند خطاهای سری 5xx (خطاهای سرور) را بازگرداند، گوگلبات به طور خودکار نرخ خزش را کاهش میدهد تا از فشار بیشتر بر سرور جلوگیری کند. بنابراین، داشتن یک هاستینگ قدرتمند و بهینه، اولین قدم برای داشتن ظرفیت خزش مناسب است.

چگونه ظرفیت خزش (Crawl Capacity) را بررسی کنیم؟

بررسی ظرفیت خزش یا Crawl Capacity (که به آن محدودیت نرخ خزش یا Crawl Rate Limit هم گفته میشود) متفاوت از بررسی تقاضای خزش است. این معیار به طور مستقیم به سلامت و سرعت سرور (هاست) شما بستگی دارد. در واقع، ظرفیت خزش یعنی گوگل چقدر میتواند سایت شما را بخزد، بدون اینکه عملکرد سرور شما کند شده یا با خطا مواجه شود.

گوگل همیشه سعی میکند “مهمان خوبی” باشد و به سرور شما فشار نیاورد. بنابراین، بررسی ظرفیت خزش به معنای ارزیابی عملکرد سرور شماست. در ادامه روشهای کلیدی برای انجام این کار آمده است.

۱. استفاده از گزارش آمار خزش (Crawl Stats) در سرچ کنسول

این گزارش، مستقیمترین راه برای دیدن عملکرد سایتتان از نگاه گوگلبات است. به مسیر Settings > Crawl Stats بروید و موارد زیر را به دقت بررسی کنید:

الف) نمودار میانگین زمان پاسخ (Average response time)

این نمودار مهمترین شاخص برای ارزیابی ظرفیت خزش است. این نمودار نشان میدهد که سرور شما به طور میانگین چقدر طول میکشد تا به درخواستهای گوگل پاسخ دهد.

- حالت ایدهآل: یک خط صاف و پایین در نمودار. این یعنی سرور شما سریع و پایدار است.

- حالت خطرناک: مشاهده قلهها و افزایشهای ناگهانی (Spikes). هر اسپایک نشاندهنده یک مشکل در سرور است که باعث شده گوگل سرعت خزش را کاهش دهد تا به سایت شما آسیب نزند. پایین و پایدار نگه داشتن این نمودار باید اولویت اصلی شما باشد.

ب) وضعیت هاست (Host status)

در بالای گزارش، بخشی به نام “Host status” وجود دارد. مطمئن شوید که تمام موارد (مانند Robots.txt fetching, DNS, و Server connectivity) تیک سبز دارند. هرگونه خطا در این بخش، به خصوص در اتصال به سرور (Server connectivity)، به شدت روی ظرفیت خزش شما تأثیر منفی میگذارد.

ج) بررسی خطاها بر اساس نوع پاسخ (By response)

در جدول تفکیک درخواستهای خزش، به دنبال خطاهای سرور بگردید.

- خطاهای سرور (Server error 5xx): این خطاها (مانند 500 یا 503) بدترین نوع خطا برای ظرفیت خزش هستند. آنها مستقیماً به گوگل میگویند که سرور شما ناپایدار است و نمیتواند درخواستها را مدیریت کند. در نتیجه، گوگل فوراً نرخ خزش را کاهش میدهد. تعداد این خطاها باید همیشه نزدیک به صفر باشد.

۲. استفاده از ابزارهای تست سرعت سایت

شما میتوانید به صورت پیشگیرانه و مستقل از گوگل، سلامت سرور خود را بسنجید. ابزارهایی مانند Google PageSpeed Insights، GTmetrix یا Pingdom به شما کمک میکنند.

- تمرکز بر روی TTFB (Time to First Byte): این معیار، زمان لازم برای دریافت اولین بایت داده از سرور پس از ارسال درخواست را اندازهگیری میکند. TTFB یک شاخص خالص از سرعت و سلامت سرور است. TTFB پایین به معنای سرور سریع و ظرفیت خزش بالاتر است.

۳. تحلیل لاگ فایلهای سرور (روش پیشرفته)

این روش به شما دقیقترین دید را میدهد. با تحلیل لاگها میتوانید ببینید:

- گوگلبات با چه فاصلههای زمانی به سایت شما درخواست ارسال میکند.

- آیا پس از یک سری درخواستهای متوالی و سریع، سرور شما شروع به برگرداندن خطاهای 5xx میکند یا خیر.

اگر مشاهده کردید که با افزایش تعداد درخواستها در یک دقیقه، پاسخهای سرور کند شده یا با خطا مواجه میشوند، شما آستانه ظرفیت خزش سرور خود را پیدا کردهاید.

نتیجهگیری کلیدی:

بررسی ظرفیت خزش یعنی نظارت بر سرعت و پایداری سرور. دو هدف اصلی شما باید این باشد:

- پایین و ثابت نگه داشتن میانگین زمان پاسخ (Average response time).

- به صفر رساندن تعداد خطاهای سرور (5xx).

یک سرور سریع و قابل اعتماد، به گوگل اجازه میدهد تا با خیال راحت و با سرعت بالا در سایت شما بخزد و این یعنی شما ظرفیت خزش بالایی دارید.

تقاضای خزش (Crawl Demand)

تقاضای خزش، میزان تمایل و اشتیاق گوگل برای خزیدن در وبسایت شما را نشان میدهد. حتی اگر سرور شما ظرفیت پردازش درخواستهای زیادی را داشته باشد، اگر گوگل محتوای سایت شما را ارزشمند و محبوب نداند، تمایلی به صرف منابع خود برای خزیدن در آن نخواهد داشت. تقاضای خزش تحت تأثیر دو عامل اصلی قرار دارد: محبوبیت و تازگی. محبوبیت به تعداد و کیفیت بکلینکهایی که از سایتهای دیگر به صفحات شما داده شده، اشاره دارد. هرچه صفحات شما از منابع معتبرتری لینک دریافت کنند، از نظر گوگل محبوبتر و مهمتر تلقی میشوند. عامل دوم، یعنی تازگی (Freshness)، به این معناست که گوگل تمایل دارد محتواهای جدید و بهروزرسانیشده را سریعتر ایندکس کند تا نتایج جستجو همواره تازه و مرتبط باقی بمانند. بنابراین، وبسایتهایی که به طور منظم محتوای باکیفیت و جدید منتشر میکنند یا محتوای قدیمی خود را بهروزرسانی میکنند، تقاضای خزش بالاتری را تجربه خواهند کرد.

چگونه تقاضای خزش (Crawl Demand) را بررسی کنیم؟

برای بررسی تقاضای خزش (Crawl Demand)، باید بدانید که این یک معیار مستقیم و عددی نیست که در ابزاری نمایش داده شود. در واقع، تقاضای خزش، تمایل و اشتیاق گوگل برای خزیدن در سایت شماست که بر اساس دو فاکتور اصلی شکل میگیرد: محبوبیت (Popularity) و تازگی (Freshness).

بنابراین، برای ارزیابی آن باید به سراغ تحلیل نشانههای غیرمستقیم بروید. در ادامه بهترین روشها برای این کار آمده است:

۱. استفاده از گزارش آمار خزش (Crawl Stats) در سرچ کنسول

این گزارش بهترین دوست شما برای درک رفتار گوگل در سایتتان است.

- روند کلی درخواستهای خزش (Total crawl requests): به مسیر

Settings > Crawl Statsبروید. اگر نمودار کلی درخواستهای خزش روندی صعودی دارد، این یک سیگنال مثبت و قوی از افزایش تقاضای خزش است. یعنی گوگل به طور فزایندهای علاقهمند به بررسی سایت شماست. - بررسی هدف خزش (By purpose):

- Refresh: این بخش نشان میدهد گوگل چند بار برای بررسی مجدد و بهروزرسانی صفحات قبلاً ایندکس شده به سایت شما سر زده است. درصد بالای “Refresh” یعنی گوگل محتوای شما را ارزشمند میداند و مرتباً آن را برای یافتن تغییرات جدید چک میکند که نشانه خوبی از تقاضای خزش است.

- Discovery: این بخش مربوط به کشف URLهای کاملاً جدید است.

نکته کلیدی: افزایش پایدار در تعداد کل خزشها و درصد بالای خزشهای “Refresh”، نشاندهنده تقاضای بالای خزش است.

۲. تحلیل سرعت ایندکس شدن محتوای جدید

یکی از بهترین و عملیترین راهها برای سنجش تقاضای خزش، بررسی سرعت ایندکس شدن محتوای شماست.

- وقتی یک مقاله جدید منتشر میکنید یا یک صفحه مهم را بهروزرسانی میکنید، زمان ایندکس شدن آن را زیر نظر بگیرید.

- میتوانید با استفاده از دستور

site:yourdomain.com/new-pageدر گوگل یا ابزار URL Inspection در سرچ کنسول، وضعیت ایندکس را بررسی کنید.

اگر صفحات جدید شما به سرعت (مثلاً در عرض چند ساعت تا یک روز) ایندکس میشوند، این یعنی تقاضای خزش بالایی دارید و گوگل مشتاقانه منتظر محتوای جدید شماست.

۳. بررسی گزارش لینکها (Links Report)

محبوبیت، یکی از دو ستون اصلی تقاضای خزش است و بکلینکها نماینده اصلی محبوبیت هستند.

- به بخش Links در سرچ کنسول بروید.

- گزارش Top linking sites (بکلینکها) را بررسی کنید. افزایش تعداد دامنههایی که به شما لینک میدهند (مخصوصاً از سایتهای معتبر)، به گوگل سیگنال میدهد که سایت شما منبع مهمی است و این موضوع مستقیماً تقاضا برای خزش آن را بالا میبرد.

۴. تحلیل لاگ فایلهای سرور (روش پیشرفته)

این دقیقترین روش موجود است. با تحلیل لاگهای سرور، میتوانید ببینید ربات گوگل (Googlebot) دقیقاً:

- چند وقت یکبار به سایت شما سر میزند.

- کدام صفحات را بیشتر از بقیه میخزد.

- چه زمانی برای بررسی مجدد یک صفحه بازمیگردد.

افزایش فرکانس بازدید گوگلبات از صفحات کلیدی شما، مستقیماً به معنای افزایش تقاضای خزش برای آن صفحات است.

به طور خلاصه، شما تقاضای خزش را با ترکیب دادههای گزارش Crawl Stats، سرعت ایندکس محتوای تازه و روند رشد بکلینکها ارزیابی میکنید.

اهمیت بودجه خزش در سئو

شاید در نگاه اول، بودجه خزش برای وبسایتهای کوچک با چند ده یا چند صد صفحه، چندان مهم به نظر نرسد، زیرا گوگل معمولاً در یافتن و ایندکس کردن این تعداد صفحه مشکلی ندارد. اما اهمیت «کرال باجت» زمانی آشکار میشود که با یک وبسایت بزرگ، مانند یک سایت خبری با هزاران مقاله یا یک فروشگاه اینترنتی با دهها هزار محصول، روبرو هستیم. در چنین مقیاسی، مدیریت صحیح بودجه خزش به یک عامل حیاتی برای موفقیت در سئو تبدیل میشود. اگر بودجه خزش به درستی مدیریت نشود، رباتهای گوگل ممکن است زمان و منابع ارزشمند خود را صرف خزیدن در صفحات بیاهمیت، تکراری یا کمارزش کنند و در نتیجه، صفحات جدید و مهم شما برای مدت طولانی از چشم گوگل پنهان بمانند.

اهمیت این موضوع را میتوان در چند جنبه کلیدی خلاصه کرد. اولاً، **سرعت ایندکس شدن**: هرچه بودجه خزش شما بهینهتر باشد، صفحات جدید و محتوای بهروزرسانیشده شما سریعتر توسط گوگل کشف و ایندکس میشوند. این امر به ویژه برای وبسایتهای خبری، فروشگاههایی که محصولات فصلی عرضه میکنند یا وبسایتهایی که در حوزههای رقابتی فعالیت دارند، بسیار حیاتی است. ثانیاً، **جلوگیری از سرقت محتوا**: اگر محتوای شما دیر ایندکس شود، این فرصت برای سایتهای سودجو فراهم میشود تا محتوای شما را کپی کرده و زودتر از شما ایندکس کنند. در این حالت، ممکن است گوگل سایت شما را به عنوان منبع کپی شناسایی کند که آسیب جدی به اعتبار و رتبه شما وارد میکند. ثالثاً، **کارایی تلاشهای سئو**: شما زمان و هزینه زیادی را صرف تولید محتوا، بهینهسازی صفحات و سئو فنی میکنید. اگر این صفحات توسط گوگل دیده نشوند، تمام این تلاشها بیثمر خواهد بود. بهینهسازی بودجه خزش تضمین میکند که سرمایهگذاری شما در سئو به بهترین شکل ممکن به نتیجه برسد و گوگل به سرعت تغییرات مثبت اعمال شده در سایت را شناسایی و در رتبهبندی لحاظ کند. در نهایت، با مدیریت صحیح بودجه خزش، شما کنترل بیشتری بر نحوه تعامل گوگل با سایت خود خواهید داشت و میتوانید اطمینان حاصل کنید که ارزشمندترین داراییهای دیجیتال شما همواره در دسترس موتور جستجو قرار دارند.

فاکتور های تعیین کننده کرال باجت

همانطور که اشاره شد، بودجه خزش مفهومی مطلق نیست و برای هر وبسایت به صورت منحصر به فرد و بر اساس مجموعهای از فاکتورها تعیین میشود. گوگل با ارزیابی این عوامل، تصمیم میگیرد که چه مقدار از منابع خود را به خزیدن در یک سایت خاص اختصاص دهد. شناخت این فاکتورها به مدیران وبسایت و متخصصان سئو کمک میکند تا استراتژیهای موثری برای بهبود و بهینهسازی بودجه خزش خود تدوین کنند. این فاکتورها را میتوان به دو دسته کلی مرتبط با «ظرفیت خزش» و «تقاضای خزش» تقسیمبندی کرد.

فاکتورهای مرتبط با ظرفیت خزش (Crawl Rate Limit)

- سلامت و سرعت سرور (Server Health & Speed): این مهمترین فاکتور در تعیین ظرفیت خزش است. سروری که به سرعت و بدون خطا به درخواستهای گوگلبات پاسخ میدهد، نشاندهنده سلامت و قدرت آن است. زمان پاسخگویی پایین سرور (Time to First Byte – TTFB) و عدم وجود خطاهای 5xx (مانند 500 Internal Server Error یا 503 Service Unavailable) به گوگل این سیگنال را میدهد که میتواند بدون ایجاد مشکل، تعداد درخواستهای بیشتری را ارسال کند. بالعکس، سرور کند و ناپایدار، گوگل را مجبور به کاهش نرخ خزش میکند.

- تنظیمات در گوگل سرچ کنسول: هرچند گوگل دیگر به وبمستران اجازه نمیدهد که مستقیماً نرخ خزش را به صورت دلخواه محدود کنند (این قابلیت در گذشته وجود داشت)، اما همچنان به صورت هوشمند این نرخ را مدیریت میکند. با این حال، بررسی گزارشهای سرچ کنسول، به خصوص گزارش «آمار خزش» (کرال کاورج)، میتواند دیدگاه ارزشمندی در مورد نحوه تعامل گوگل با سرور شما و مشکلات احتمالی ارائه دهد.

فاکتورهای مرتبط با تقاضای خزش (Crawl Demand)

- محبوبیت (Popularity): صفحاتی که از وبسایتهای معتبر و مرتبط دیگر بکلینک دریافت میکنند، از نظر گوگل محبوب و مهم تلقی میشوند. این محبوبیت، تقاضا برای خزش آن صفحات را افزایش میدهد. لینکهای داخلی نیز در این زمینه نقش مهمی ایفا میکنند؛ صفحاتی که از نقاط مختلف سایت شما لینکهای داخلی دریافت میکنند، به عنوان صفحات مهم شناسایی شده و بیشتر مورد خزش قرار میگیرند.

- تازگی (Freshness): گوگل همواره به دنبال محتوای تازه است. وبسایتهایی که به طور منظم محتوای جدید منتشر میکنند یا صفحات قدیمی خود را با اطلاعات جدید و ارزشمند بهروز میکنند، گوگل را تشویق به خزش مکرر میکنند. این فاکتور به خصوص برای سایتهای خبری و وبلاگها اهمیت بالایی دارد.

- ساختار سایت و سایت مپ (Site Structure & Sitemap): یک ساختار سایت منطقی و معماری اطلاعات منظم به گوگل کمک میکند تا به راحتی صفحات مهم را کشف کرده و ارتباط بین آنها را درک کند. ارائه یک نقشه سایت (Sitemap) دقیق و بهروز از طریق گوگل سرچ کنسول، راهنمای مستقیمی برای رباتهای خزش است و تضمین میکند که هیچ صفحه مهمی از قلم نیفتد. ساختار ضعیف و وجود صفحات یتیم (Orphan Pages) که هیچ لینک داخلی دریافت نمیکنند، کشف آنها را برای گوگل دشوار میسازد.

- نوع و کیفیت محتوا: محتوای باکیفیت، جامع و منحصربهفرد که نیاز کاربر را به خوبی برطرف میکند، سیگنال مثبتی برای گوگل است. صفحاتی با محتوای کوتاه، بیکیفیت یا تکراری (Duplicate Content) نه تنها ارزش کمی برای کاربر دارند، بلکه تقاضای خزش را نیز کاهش میدهند و باعث هدر رفتن بودجه خزش میشوند.

نحوه عملکرد خزنده های گوگل

برای درک عمیقتر بودجه خزش، لازم است با مکانیزم کاری رباتهای خزنده گوگل (Googlebot) آشنا شویم. این فرآیند پیچیده و چندمرحلهای، سنگ بنای عملکرد موتور جستجوی گوگل است. خزیدن، فرآیندی است که طی آن گوگلبات میلیاردها صفحه موجود در وب را کشف کرده و محتوای آنها را برای مرحله بعدی، یعنی ایندکس کردن، جمعآوری میکند. این عملیات به صورت مداوم و در مقیاسی غیرقابل تصور در حال انجام است.

همه چیز با یک لیست اولیه از آدرسهای وب (URLها) شروع میشود. این لیست از خزشهای قبلی و همچنین از طریق نقشههای سایتی (Sitemaps) که توسط مدیران وبسایتها در گوگل سرچ کنسول ثبت میشود، به دست میآید. گوگلبات با مراجعه به این URLها، محتوای هر صفحه را میخواند. در حین خواندن یک صفحه، ربات تمام لینکهای موجود در آن (لینکهای داخلی و خارجی) را شناسایی کرده و آنها را به لیست صفحاتی که باید در آینده بخزد، اضافه میکند. این فرآیند شبیه به تار عنکبوت است که از یک نقطه شروع شده و به طور مداوم گسترش مییابد و صفحات جدید را کشف میکند.

گوگلبات فقط به کشف صفحات جدید اکتفا نمیکند. این ربات به طور هوشمند تغییرات در سایتهای موجود و لینکهای خراب (Broken Links) را نیز شناسایی میکند. الگوریتمهای پیچیده گوگل تعیین میکنند که کدام سایتها، با چه فرکانسی و کدام صفحات از آن سایت باید در اولویت خزش قرار گیرند. برای مثال، صفحه اصلی یک وبسایت خبری معتبر ممکن است هر چند دقیقه یک بار خزیده شود، در حالی که یک صفحه مقاله قدیمی در یک وبلاگ شخصی شاید هر چند ماه یک بار مورد بازبینی قرار گیرد.

پس از اینکه محتوای یک صفحه توسط خزنده خوانده شد، این اطلاعات به سرورهای گوگل ارسال میشود تا در مرحله بعدی، یعنی «ایندکسسازی» (Indexing)، پردازش شود. در این مرحله، گوگل محتوای متنی، تصویری، ویدیویی و سایر المانهای صفحه را تحلیل کرده و سعی میکند موضوع اصلی آن را درک کند. این اطلاعات در یک پایگاه داده عظیم به نام «ایندکس گوگل» ذخیره میشود. تنها صفحاتی که با موفقیت خزیده و ایندکس شدهاند، شانس حضور در نتایج جستجو را خواهند داشت. بنابراین، فرآیند خزش، دروازه ورود به دنیای گوگل است و بودجه خزش، کلید عبور از این دروازه محسوب میشود.

چه زمانی نگران بودجه خزش باشیم؟

همانطور که گری ایلیس (Gary Illyes)، تحلیلگر ارشد وبمستر در گوگل، بارها اشاره کرده است، اکثر وبسایتها، به خصوص سایتهای کوچک تا متوسط، نیازی نیست که به طور وسواسگونه نگران بودجه خزش خود باشند. الگوریتمهای گوگل در کشف، خزش و ایندکس کردن محتوای جدید بسیار کارآمد هستند. با این حال، سناریوهای خاصی وجود دارد که در آنها، بودجه خزش به یک دغدغه جدی و یک فاکتور کلیدی در استراتژی سئو تبدیل میشود. عدم توجه به کرال باجت در این شرایط میتواند منجر به مشکلات قابل توجهی در دیده شدن سایت در نتایج جستجو شود.

شناسایی این شرایط به شما کمک میکند تا تشخیص دهید آیا بهینهسازی بودجه خزش باید در اولویت کاری شما قرار گیرد یا خیر. در ادامه به مهمترین موقعیتهایی که در آنها باید به کرال باجت توجه ویژهای داشته باشید، اشاره میکنیم:

- وبسایتهای بسیار بزرگ (Large Websites): اگر شما یک وبسایت با هزاران یا میلیونها صفحه را مدیریت میکنید (مانند یک پلتفرم تجارت الکترونیک بزرگ، یک سایت خبری بینالمللی یا یک دایرکتوری جامع)، بودجه خزش به یک عامل حیاتی تبدیل میشود. در این مقیاس، حتی اگر گوگلبات روزانه هزاران صفحه از سایت شما را بخزد، باز هم ممکن است ماهها طول بکشد تا تمام صفحات شما را کشف کند. بهینهسازی بودجه خزش در این سایتها تضمین میکند که رباتها ابتدا به مهمترین صفحات (مانند صفحات دستهبندی اصلی، محصولات پرفروش یا مقالات جدید) سر بزنند.

- اضافه کردن ناگهانی تعداد زیادی صفحه: اگر به تازگی بخش جدیدی به سایت خود اضافه کردهاید (مثلاً یک وبلاگ با صدها مقاله راهاندازی کردهاید یا هزاران محصول جدید را به فروشگاه خود افزودهاید)، باید اطمینان حاصل کنید که گوگل منابع کافی برای خزش و ایندکس کردن سریع این حجم از محتوای جدید را در اختیار دارد. بدون یک استراتژی مشخص برای هدایت رباتها، ممکن است این صفحات جدید برای مدت طولانی در صف خزش باقی بمانند.

- وجود تعداد زیادی ریدایرکت: زنجیرههای طولانی ریدایرکت (Redirect Chains) و تعداد زیاد صفحات ریدایرکت شده (مانند 301 و 302) میتوانند بخش قابل توجهی از بودجه خزش شما را مصرف کنند. هر ریدایرکت یک درخواست اضافه برای گوگلبات محسوب میشود. اگر ربات برای رسیدن به صفحه مقصد مجبور باشد از چندین ریدایرکت عبور کند، ممکن است پیش از رسیدن به محتوای اصلی، از ادامه مسیر منصرف شود. این مسئله به خصوص پس از مهاجرت سایت یا تغییر ساختار URLها اهمیت پیدا میکند.

- مشکلات در ایندکس شدن صفحات: اگر متوجه شدهاید که صفحات جدید و مهم شما با تأخیر زیاد ایندکس میشوند یا اصلاً ایندکس نمیشوند (در حالی که از نظر فنی مشکلی ندارند)، این میتواند یک نشانه قوی از مشکلات مربوط به بودجه خزش باشد. بررسی گزارشهای گوگل سرچ کنسول، به ویژه گزارش Coverage و Crawl Stats، میتواند به شناسایی این مشکل کمک کند.

راه ها و ترفند های افزایش بودجه خزش در سایت ها (فروشگاهی، شرکتی)

بهینهسازی بودجه خزش به معنای آن است که به گوگلبات کمک کنیم تا صفحات مهم سایت ما را سریعتر و بهینهتر پیدا کند و زمان خود را صرف URLهای بیارزش نکند. این فرآیند مجموعهای از اقدامات در حوزه سئو فنی، محتوا و ساختار سایت را در بر میگیرد. استراتژیها ممکن است بسته به نوع سایت (مثلاً یک طراحی سایت فروشگاهی در مقابل یک طراحی سایت شرکتی) کمی متفاوت باشد، اما اصول کلی یکسان است. هدف نهایی، افزایش «تقاضای خزش» و بهبود «ظرفیت خزش» است.

بهبود ظرفیت خزش (افزایش سرعت و سلامت سایت)

- افزایش سرعت سایت: این یکی از موثرترین روشها برای بهبود بودجه خزش است. هرچه سایت شما سریعتر بارگذاری شود، گوگلبات میتواند در مدت زمان یکسان، تعداد صفحات بیشتری را بخزد. بر اساس گفتههای گوگل، سرعت سایت یک فاکتور مهم در تعیین نرخ خزش است. برای افزایش سرعت، روی بهینهسازی تصاویر، کاهش کدهای CSS و JavaScript، فعالسازی کش مرورگر و استفاده از شبکه توزیع محتوا (CDN) تمرکز کنید. زمان پاسخگویی سرور (TTFB) را به دقت زیر نظر داشته باشید و در صورت لزوم، هاستینگ خود را ارتقا دهید.

- کاهش خطاهای سرور: به طور منظم گزارش Coverage در سرچ کنسول را برای یافتن خطاهای سرور (Server errors 5xx) بررسی کنید. این خطاها به شدت به ظرفیت خزش شما آسیب میزنند، زیرا به گوگل میگویند که سرور شما ناپایدار است. با همکاری تیم فنی یا پشتیبانی هاستینگ، این خطاها را در اسرع وقت برطرف کنید.

افزایش تقاضای خزش (هدایت گوگل به صفحات مهم)

- مدیریت لینکسازی داخلی: لینکسازی داخلی قدرتمند، بهترین راه برای نشان دادن صفحات مهم به گوگل است. صفحاتی که بیشترین لینک داخلی را دریافت میکنند، از نظر گوگل مهمتر تلقی شده و بیشتر خزیده میشوند. اطمینان حاصل کنید که تمام صفحات مهم شما از طریق منوی اصلی، فوتر یا لینکهای متنی در محتوای صفحات دیگر قابل دسترسی هستند. از ایجاد صفحات یتیم (Orphan Pages) که هیچ لینک داخلی ندارند، جداً خودداری کنید.

- بهینهسازی نقشه سایت (Sitemap): یک فایل `sitemap.xml` تمیز، بهروز و بدون خطا ایجاد کرده و آن را در سرچ کنسول ثبت کنید. نقشه سایت باید فقط شامل URLهای کانونیکال (Canonical) و قابل ایندکس باشد. از قرار دادن URLهای ریدایرکت شده، مسدود شده توسط `robots.txt` یا نوایندکس در نقشه سایت خودداری کنید. برای سایتهای بزرگ، میتوانید از چند نقشه سایت استفاده کرده و یک فایل ایندکس نقشه سایت ایجاد کنید.

- انتشار و بهروزرسانی منظم محتوا: سیگنال تازگی (Freshness) را به گوگل ارسال کنید. با تولید محتوای جدید و باکیفیت و همچنین بهروزرسانی محتوای قدیمی و مهم، گوگل را تشویق به بازگشت مکرر به سایت خود کنید. این کار تقاضا برای خزش را به طور طبیعی افزایش میدهد.

- کسب بکلینکهای باکیفیت: بکلینکها همچنان یکی از قویترین سیگنالها برای نشان دادن اهمیت یک صفحه هستند. تلاش برای کسب لینک از وبسایتهای معتبر و مرتبط در حوزه کاری شما، تقاضای خزش را برای صفحات لینکشده به شدت افزایش میدهد. این کار به اعتبار کلی دامنه شما یا همان همیار سایت نیز کمک میکند.

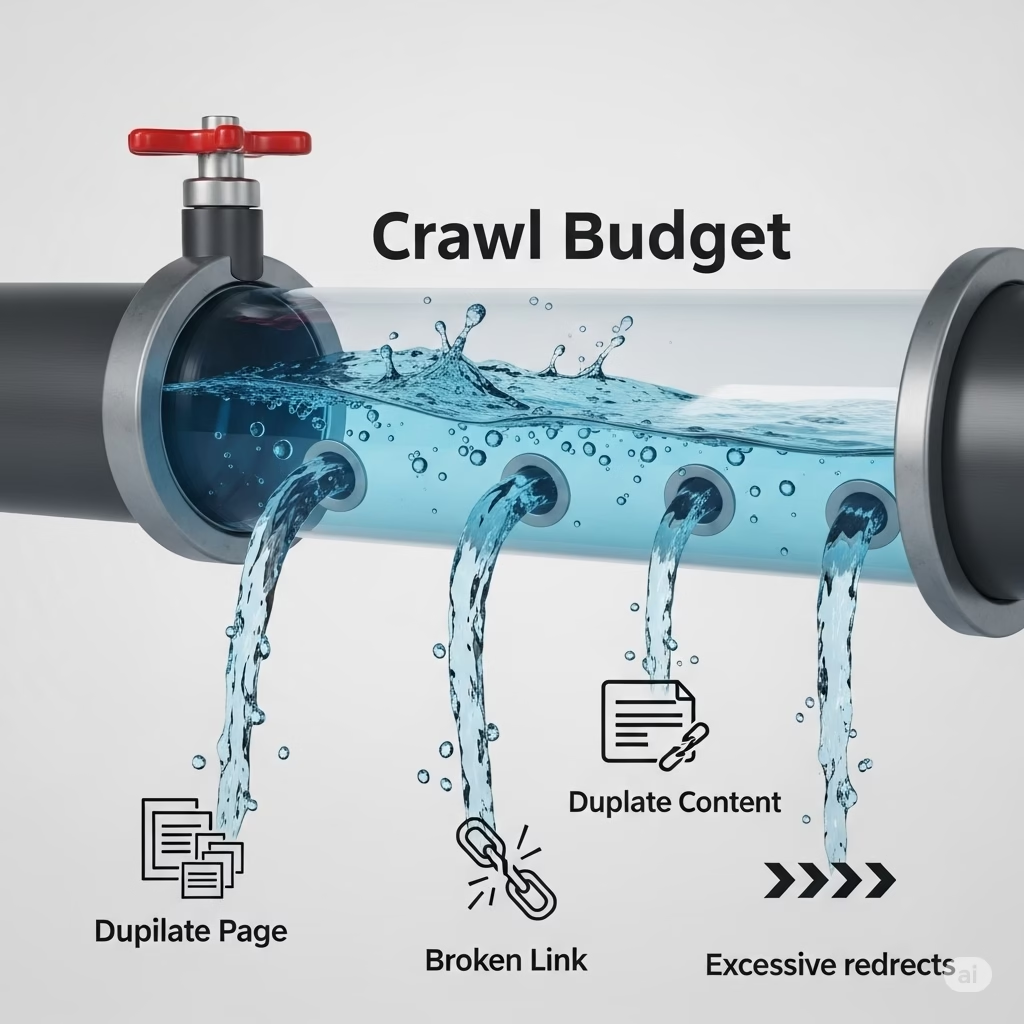

چه عواملی باعث هدر رفتن کرال باجت میشود؟

یکی از مهمترین جنبههای بهینهسازی بودجه خزش، شناسایی و حذف عواملی است که این منبع ارزشمند را هدر میدهند. گوگلبات با ورود به سایت شما، یک بودجه مشخص را صرف میکند؛ اگر این بودجه صرف خزیدن در URLهای بیاهمیت، تکراری یا مشکلساز شود، منابع کمتری برای صفحات کلیدی و محتوای اصلی شما باقی خواهد ماند. این هدررفت میتواند به طور جدی روند ایندکس شدن و در نهایت رتبهبندی سایت شما را مختل کند. شناخت این تلهها اولین قدم برای جلوگیری از آنهاست.

- محتوای تکراری (Duplicate Content): این یکی از بزرگترین قاتلان بودجه خزش است. URLهای متعددی که محتوای یکسان یا بسیار مشابهی را نمایش میدهند (مانند نسخههای www و non-www، نسخههای HTTP و HTTPS، یا پارامترهای URL که محتوا را تغییر نمیدهند)، ربات گوگل را سردرگم کرده و باعث میشوند یک محتوا چندین بار خزیده شود. استفاده صحیح از تگ کنونیکال (`rel=”canonical”`) برای مشخص کردن نسخه اصلی و ترجیحی یک صفحه، راه حل اصلی این مشکل است.

- صفحات با محتوای کمارزش (Thin Content): صفحاتی که محتوای بسیار کمی دارند، به کاربر ارزش خاصی اضافه نمیکنند و از نظر گوگل نیز بیاهمیت تلقی میشوند. این صفحات شامل صفحات تگ، آرشیوهای تاریخ یا نویسنده (در صورتی که بهینه نشده باشند)، نتایج جستجوی داخلی سایت و صفحات خالی میشوند. ایندکس شدن این صفحات نه تنها کمکی به سئوی شما نمیکند، بلکه بودجه خزش را نیز هدر میدهد. بهتر است این صفحات را با استفاده از تگ `noindex` از ایندکس گوگل خارج کنید.

- ریدایرکتهای زنجیرهای و شکسته (Redirect Chains & Broken Redirects): همانطور که قبلاً ذکر شد، هر ریدایرکت یک پرش برای گوگلبات است. اگر رسیدن به صفحه نهایی نیازمند عبور از چندین ریدایرکت باشد (مثلاً صفحه A به B، B به C و C به D ریدایرکت شود)، ممکن است گوگلبات در میانه راه خسته شده و از ادامه خزش منصرف شود. همیشه سعی کنید ریدایرکتها را به صورت مستقیم به آدرس نهایی انجام دهید. همچنین لینک دادن به صفحاتی که ریدایرکت میشوند یا خطای 404 برمیگردانند (لینکهای شکسته) نیز مصداق بارز هدر دادن بودجه خزش است.

- پارامترهای URL و ناوبری فیلترشده (Faceted Navigation & URL Parameters): در سایتهای فروشگاهی، استفاده از فیلترها (مثلاً بر اساس رنگ، اندازه، قیمت) میتواند هزاران URL جدید با پارامترهای مختلف ایجاد کند (مانند `example.com/dresses?color=red&size=m`). اگر این URLها به درستی مدیریت نشوند، گوگلبات در یک حلقه بیپایان از URLهای تکراری یا تقریباً تکراری گرفتار میشود. باید با استفاده از فایل `robots.txt` یا تگ کنونیکال، به گوگل بفهمانید که کدام پارامترها را نادیده بگیرد و کدام نسخه از صفحه را ایندکس کند.

- عدم استفاده صحیح از فایل Robots.txt: فایل `robots.txt` ابزاری قدرتمند برای جلوگیری از خزش بخشهای غیرضروری سایت است. با مسدود کردن دسترسی رباتها به مناطقی مانند صفحات ورود ادمین، سبد خرید، یا نتایج جستجوی داخلی، میتوانید بودجه خزش خود را ذخیره کرده و آن را به سمت صفحات مهم هدایت کنید. البته باید دقت کرد که به اشتباه صفحات مهم یا فایلهای CSS و JS را مسدود نکنید، زیرا این کار مانع از رندر صحیح صفحه توسط گوگل میشود.

روش های بررسی و کنترل کرال باجت

بهینهسازی بودجه خزش یک فرآیند یکباره نیست، بلکه نیازمند بررسی، تحلیل و کنترل مداوم است. خوشبختانه، ابزارهای قدرتمندی برای این کار وجود دارد که به شما امکان میدهد رفتار گوگلبات در سایت خود را به دقت زیر نظر بگیرید و مشکلات احتمالی را شناسایی کنید. اصلیترین و مهمترین ابزار در این زمینه، گوگل سرچ کنسول است، اما تحلیل لاگ فایلهای سرور نیز میتواند دیدگاههای عمیقتری را در اختیار شما قرار دهد.

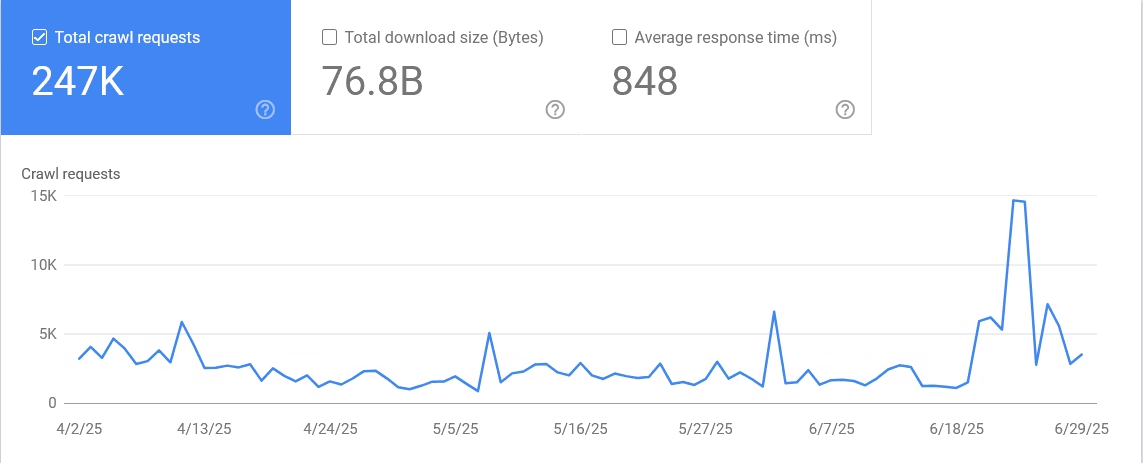

استفاده از گزارش آمار خزش (Crawl Stats) در سرچ کنسول

این گزارش که در بخش “Settings” گوگل سرچ کنسول قرار دارد، گنجینهای از اطلاعات در مورد نحوه خزش سایت شما توسط گوگل است. این گزارش به شما نشان میدهد که در ۹۰ روز گذشته، گوگلبات چند درخواست به سایت شما ارسال کرده (Total crawl requests)، حجم کل دادههای دانلود شده چقدر بوده (Total download size) و میانگین زمان پاسخگویی سرور شما چقدر است (Average response time). بررسی این نمودارها به شما کمک میکند تا سلامت کلی سرور و ظرفیت خزش خود را ارزیابی کنید. افزایش ناگهانی در زمان پاسخگویی میتواند نشاندهنده مشکلات سرور باشد.

این گزارش همچنین اطلاعات را بر اساس نوع پاسخ (مانند OK 200، ریدایرکتها، خطاهای 404 و خطاهای سرور)، نوع فایل (HTML, CSS, JavaScript, Image) و هدف خزش (کشف یا تازهسازی) تفکیک میکند. با تحلیل این دادهها میتوانید:

- شناسایی مشکلات: آیا تعداد زیادی خطای 404 یا 5xx وجود دارد که بودجه شما را هدر میدهد?

- درک رفتار گوگل: آیا گوگل در حال خزیدن فایلهای CSS و JS شما هست تا بتواند صفحات را به درستی رندر کند?

- بررسی URLهای ناخواسته: با بررسی بخش “By Googlebot type” و مشاهده “Example URLs”، میتوانید ببینید آیا گوگل در حال خزیدن در URLهایی است که شما انتظارش را ندارید (مانند URLهای با پارامترهای پیچیده).

تحلیل لاگ فایلهای سرور (Server Log File Analysis)

این روش، پیشرفتهترین و دقیقترین راه برای درک کامل بودجه خزش است. لاگهای سرور، رکوردی از تمام درخواستهایی است که به سرور شما ارسال میشود، از جمله درخواستهای ارسال شده توسط گوگلبات و سایر رباتها. با تحلیل این فایلها (که معمولاً نیاز به ابزارهای تخصصی مانند Screaming Frog Log File Analyser یا راهکارهای سفارشی دارد)، میتوانید به سوالات زیر پاسخ دهید:

- گوگلبات دقیقاً کدام صفحات را میخزد و با چه فرکانسی؟

- کدام صفحات بیشترین بودجه خزش را به خود اختصاص میدهند؟ آیا این صفحات همان صفحات مهم شما هستند؟

- آیا بودجه خزش صرف صفحات ریدایرکت شده، دارای خطا یا غیرکانونیکال میشود؟

- آخرین باری که گوگلبات یک صفحه مهم را خزیده، چه زمانی بوده است؟

- آیا رباتهای دیگری (مفید یا مضر) در حال خزیدن در سایت شما هستند؟

تحلیل لاگ فایلها به شما یک دید بدون فیلتر و کاملاً واقعی از نحوه تعامل رباتهای جستجو با سایتتان میدهد و به شما اجازه میدهد تا استراتژیهای بهینهسازی بودجه خزش را با دقت بسیار بالاتری تدوین و اجرا کنید.

نتیجهگیری

بودجه خزش یا کرال باجت، مفهومی فراتر از یک اصطلاح فنی در دنیای سئو است؛ این مفهوم، نمایانگر اقتصاد توجه در اکوسیستم موتورهای جستجوست. در جهانی که منابع گوگل برای خزش نامحدود نیست، موفقیت یک وبسایت در گرو توانایی آن برای جلب و هدایت هوشمندانه این توجه محدود است. نادیده گرفتن بودجه خزش، بهویژه برای وبسایتهای بزرگ و پویا، مانند ساختن یک کتابخانه باشکوه با راهروهای تاریک و بدون نقشه راهنماست؛ کتابهای ارزشمند (صفحات مهم) ممکن است هرگز توسط کتابداران (رباتهای گوگل) پیدا نشوند.

بهینهسازی بودجه خزش یک ماراتن است، نه یک دوی سرعت. این فرآیند نیازمند یک رویکرد جامع است که از سلامت و سرعت سرور آغاز میشود، با ایجاد یک ساختار سایت منطقی و لینکسازی داخلی قدرتمند ادامه مییابد و با مدیریت دقیق URLهای بیارزش و تکراری به اوج خود میرسد. با استفاده هوشمندانه از ابزارهایی مانند گوگل سرچ کنسول و تحلیل لاگهای سرور، میتوانیم نبض تعامل گوگل با وبسایتمان را در دست بگیریم و اطمینان حاصل کنیم که هر قطره از بودجه خزش، صرف ارزشمندترین داراییهای دیجیتال ما میشود. در نهایت، سایتی که به بودجه خزش خود احترام میگذارد، به گوگل نشان میدهد که برای زمان و منابع آن ارزش قائل است و در مقابل، گوگل نیز با ایندکس سریعتر و توجه بیشتر، این احترام را پاسخ خواهد داد.